O SPSS gera muitas tabelas de saída para uma

análise de regressão linear múltipla. Mostramos aqui apenas as três tabelas

principais, que precisam ser entendidas por quem deve discutir os resultados

do ajuste de uma regressão múltipla.

A saída

completa do SPSS para a regressão linear múltipla permite verificar se as

pressuposições básicas para a análise estão satisfeitas. Mas vamos supor aqui que você já verificou que seus dados atendem às premissas necessárias

para fornecer um resultado válido.

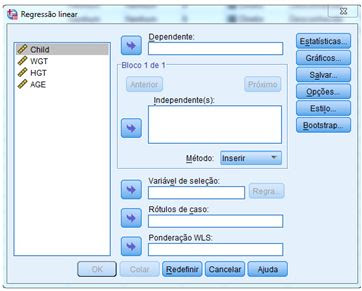

Procedendo ao cálculo da regressão linear múltipla

usando o exemplo dado na postagem anterior (Regressão linear múltipla no SPSS),

obtemos a primeira tabela de interesse, isto é, a tabela Resumo do Modelo. Esta

tabela fornece R, R2, R2 ajustado e o erro padrão

da estimativa, que pode ser usado para determinar quão bem um

modelo de regressão se ajusta aos dados.

O valor R

é o coeficiente de correlação múltipla.

É uma medida da qualidade da previsão da variável dependente, que neste exemplo

é o peso da criança, (WGT), dado em libras. Um valor de 0,883 indica bom nível

de previsão.

O

valor R2 é o coeficiente

de determinação. É a proporção de variação na variável dependente explicada

pelas variáveis independentes. O valor R2 = 0,780 mostra que as variáveis independentes explicam 78,0% da variação da variável dependente, WGT (peso). Você também precisa saber interpretar "R2 ajustado", mas vamos

explicar isso em próxima postagem.

A segunda tabela de interesse é a tabela de

análise de variância, ou tabela de ANOVA (do inglês, ANOVA table), mostrada em

seguida.

O teste F

(Z na tabela de ANOVA) testa o ajuste

do modelo de regressão. A tabela mostra que as variáveis independentes (AGE, HGT) preveem a variável dependente (WGT) de forma significativa

porque p e menor que 0,05. Em outras

palavras, o modelo de regressão se ajusta bem aos dados.

A terceira tabela de interesse é aquela que

apresenta os coeficientes de regressão. Veja em seguida.

Coeficientes não

padronizados indicam quanto a variável dependente varia com uma variável

independente, quando as outras variáveis independentes

são mantidas constantes. Considere o efeito da idade, neste exemplo. Como

mostra a tabela, o coeficiente não padronizado para idade (AGE) é igual a 2,050.

Isso significa que, para cada aumento de um ano na idade, há um aumento no peso

(WGT) de 2,050 libras (lembre-se de que peso está medido em libras).

O teste t, apresentado na tabela, testa se os

coeficientes não padronizados (ou padronizados) são iguais a zero

na população. Se p < 0,05, você

pode concluir que os coeficientes são significantemente diferentes de zero. O

valor t, e o valor p

correspondente estão localizados nas colunas "t" e "Sig",

respectivamente. Verifique que o coeficiente de altura (HGT) é significante.

Agora, com base nos dados de peso, altura e

idade de 12 crianças, você pode escrever:

Foi ajustada uma regressão linear múltipla para

prever o peso em função da altura e da idade de crianças. Obteve-se:

Somente a variável altura (HGT) foi significante ao nível de 5%,

mas a variável idade (AGE) pode ser entendida como significante ao nível p =0,056,

valor muito próximo de 5% de significância, usado convencionalmente.

NOTA: A amostra é muito pequena e constituída por dados fictícios. Portanto,

a conclusão não é válida na prática. Foi usada aqui apenas para facilitar os

cálculos e dar, a quem lê, uma referência importante (KLEINBAUM E KUPPER). Os

dados não foram transformados no sistema decimal porque não dariam valores inteiros,

o que dificultaria a digitação.