1. Introdução

O aprendizado dos alunos é medido, classicamente, por meio de

testes. Beira o impossível medir o que alunos efetivamente aprendem em cursos

que tratam ética e cidadania, embora seja fácil estabelecer o conhecimento adquirido

pelo aluno em matemática ou numa língua estrangeira, a capacidade de relatar e

opinar sobre um texto escrito, o desempenho numa prova de laboratório. E

como se avalia um professor? As universidades dão bastante ênfase à produção

intelectual de seus docentes, medida principalmente por publicações. Mas como

se mede a capacidade de ensinar? Existe um esforço nesse sentido, como provam

os questionários de todas as formas e todos os tamanhos preenchidos por alunos

no final dos cursos.

Então, está na

hora de perguntar: os professores aprendem, analisando e interpretando as

respostas dadas pelos alunos nos questionários que, afinal de contas, os

avaliam? Poucas instituições dão aos professores a oportunidade de ler as avaliações

de alunos sobre seu corpo docente – isso fica com a administração. Mais do que a

resposta, no entanto, caberia entregar aos professores uma análise das

informações e alguma discussão sobre os problemas encontrados. É preciso

melhorar o ensino no Brasil.

“Nossos professores não aprenderam a ensinar

e, como conseqüência, nossos alunos não aprendem o que deveriam aprender”,

explica Castro 1. Cá do meu canto, de professora de estatística

aplicada, me pergunto: o que os alunos deveriam aprender e o que eles querem

aprender?

Tive a

oportunidade de ministrar a disciplina de Metodologia da Pesquisa Científica no

curso de pós-graduação em Bioética, na Universidade São Camilo, disciplina que

já administrei em outras oportunidades. Sempre considerei ser minha função

aguçar a crítica dos alunos diante de trabalhos científicos, ou seja, importei-me

em incentivar a ler com um pé na crítica, questionando a coleta de dados, indagando

a função da análise e buscando interpretações que fossem além daquelas já

colocadas pelos autores. Na profissão de analista, porque faço análises

estatísticas, acolhi com enlevo o interesse de muitos alunos, mas me surpreendi

com a ojeriza de alguns pelos números. Este trabalho é uma tentativa, ainda que

tênue, de entender o que os alunos querem aprender e o que deveriam aprender. Mas

vamos às falas deles.

2.

Método

2.1.

A coleta de dados

A Universidade São

Camilo adota a avaliação das atividades de docência como procedimento usual.

Essa avaliação é feita por meio de questionário elaborado por especialistas.

Depois de respondidos anonimamente, os questionários são entregues à

administração e uma cópia das respostas é encaminhada ao professor responsável

pelo curso.

Os dois grandes

tópicos do questionário – avaliação da disciplina e avaliação do docente – são

desmembrados em questões abertas, que pedem a opinião dos alunos sobre os itens

enumerados em seguida.

Avaliação da

disciplina

1. Organização

2. Conteúdo

3. Outros Itens Pertinentes

Avaliação do

docente

1. Relacionamento interpessoal

2. Habilidade de comunicação

3. Habilidades técnicas de ensino (Didática)

4. Domínio do Conteúdo

5. Outras Questões

2.2.

A amostra

Está aqui

analisado o conteúdo dos questionários respondidos por 23 alunos, 15 que

cursaram a disciplina em 2011 e 8 que cursaram a disciplina em 2012. Nem todos

responderam a todas as perguntas.

2.3.

A análise de categorias para as respostas ao questionário

Na definição de Bernard Berelson 2, análise de conteúdo é "a research technique for the objective,

systematic, and quantitative description of manifest content of communications."

Uma análise de

conteúdo 3 busca, portanto, palavras, frases, temas e conceitos

dentro de um texto e os quantifica de maneira sistemática e objetiva. O

resultado é usado para fazer inferência sobre as mensagens dentro do texto.

A análise de

categorias 4 feita neste trabalho é a mais comum das análises de conteúdo.

Nesse tipo de análise primeiramente se estabelecem categorias e depois, em cada

categoria, se encaixam unidades significativas e pertinentes de informação. As

unidades da mesma categoria devem ser homogêneas e as categorias devem ser exaustivas. Conta-se, então, o número de unidades em cada

categoria.

Para este

trabalho, foram examinadas as respostas dadas por alunos em questões abertas.

Antes, foram estabelecidas as três categorias nas quais poderiam ser encaixadas

palavras que descrevessem os seguintes tipos de avaliação: positiva, situação

de advertência e negativa. Contadas as unidades

em cada categoria, buscou-se interpretar as palavras negativamente carregadas.

3.

Resultados

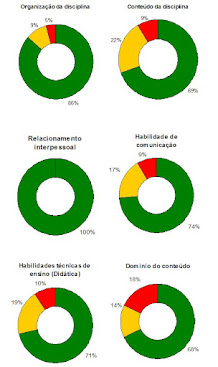

Para denominar as categorias,

foram usados os nomes das cores de semáforos: verde (aprovação), amarelo

(atenção ou, mais apropriadamente, advertência) e vermelho (desaprovação). É

animador ver os resultados. Como escreveu Drummond[1]

- eu agradeço

humildemente

Gesto assim vário e divergente...

Na análise de categorias, o interesse não é descrever o conteúdo dos textos, mas buscar inferir do que eles dizem, depois de categorizados e contados.

Muita

gente acha que é mais construtivo enfatizar aspectos positivos e evitar

mencionar o lado negativo das coisas5. No entanto, elogios nos casos

em que existe relação de dependência – como é o caso do aluno em relação ao

professor – sempre podem soar como bajulação.

De

qualquer forma, nas circunstâncias, os cumprimentos são valiosos porque foram

feitos anonimamente por alunos que nem sequer sabiam o destino das avaliações. Características

pessoais como relacionamento interpessoal, organização, habilidades técnicas de

ensino (didática), habilidade de comunicação foram bem avaliadas. A desaprovação

maior ficou por conta do conteúdo da disciplina e do domínio do conteúdo por

parte do docente, principalmente no ano de 2011.

Falhas

precisam ser apontadas para que se melhore o ensino. Então a discussão, aqui, tratará

as falas que mostram desaprovação, uma vez que a avaliação é feita para

produzir feedback e melhorar o ensino. Seguem como exemplo respostas categorizadas como

“vermelho” sobre o conteúdo da disciplina e sobre o domínio do conteúdo

por parte do docente. São cinco respostas de 2011 e uma (a última) de 2012, citadas ipsis

litteris:

1.

Não demonstrou domínio do conteúdo em vários

momentos, inclusive ressaltado ser estatística, portanto alguns tipos de

pesquisas foram tratados como de pouca credibilidade, porém sem conheci/o

suficiente p/ tal afinação.

2. Péssimo. A todo tempo ressalta que é

profissional de estatística e não de metodologia. Perguntando ao grupo as

definições.

3. Deixou a desejar, principalmente sobre pesquisa

Qualitativa. (não tem o domínio do conteúdo).

4. Ruim. A imagem que ficou é que a Prof. não

domina o assunto A mesma fala a todo momento que o negócio dela é só números.

5. No

mínimo contraditório a matéria de metodologia “BASE” para a tese ser conduzida

de foram superficial e por uma docente sem experiência em pesquisa

bibliográfica, que pelo que eu percebi é o foco do mestrado. Estas aulas não me

acrescentaram em nada, apenas confundiu princípios e definições que já tinha

claros em minha mente.

6. Cartesiana pela Formação em Estatística.

É importante deixar claro que a estatística, como técnica, não foi abordada em sala de aula, mas em 2011 foi enfatizada a necessidade de algum conhecimento na área para entender uma pesquisa. Ainda, se frisou que um grupo (CEP) que trata Ética deve ser multiprofissional, com a presença de estatístico, porque a discussão de um tema sob diferentes pontos de vista melhora o desempenho do grupo. Mas houve demasiada insistência na definição do espaço de conhecimentos da docente – com a intenção de marcar a diversidade do grupo. Mas o fato é que se dizer ser estatística causou mal estar.

Mas

é notório, para um professor que se debruce sobre o fato, que vários alunos de

pós-graduação repudiam as estatísticas. Não

acreditam nas estatísticas do IBGE, da FGV, da ONU, da OMS, do IBOPE, do SEADE.

No dizer de Castro6, aprender essa “disciplina intelectual é mais difícil do que dar palpite sobre o que

não se estudou e ainda menos se aprendeu”. Mas há também quem confunda

estatística com matemática e se reporte a Descartes[1]

para pensar nos modelos estatísticos que apareceram no século XX – e “já perpassaram todas as ciências”7.

Os

modelos estatísticos consideram o aleatório. Mas como coloca o físico Mlodinov,

“o maior desafio à compreensão da

aleatoriedade ... é o fato de que, embora os princípios dela surjam da lógica

cotidiana, muitas das consequências que se seguem a esses princípios provam-se

contra-intuitivos”.8

Uma

coisa é certa: o fato de eu ser profissional

na área de estatística mobilizou a má vontade de alguns alunos. E isso já aconteceu

em outras oportunidades. Ministrando um seminário na USP, em 2012, ao escrever

um modelo estatístico ouvi, de público, o descompasso de um médico: “Isso é

bobagem”.

No

entanto, acho adequado um profissional de estatística ministrar Metodologia da

Pesquisa Científica porque ele se prende mais à metodologia em si do que aos

métodos de trabalho. Explico-me: um médico ensinando essa disciplina relatará

artigos médicos e discutirá, por exemplo, como medir o diâmetro da aorta. O

estatístico, por seu lado, discutirá trabalhos de várias áreas e irá se

preocupar com, por exemplo, as características da amostra.

De

qualquer modo, foi maior a aceitação das aulas de Metodologia da Pesquisa

Científica no curso de pós-graduação em Bioética na Universidade São Camilo em

2012, provavelmente porque se buscou sanar a principal falha apontada em 2011

(a insistência em balizar o saber de mestre na estatística). Em 2012, foi

tratada a metodologia, sem se definir o

espaço de conhecimentos do docente. Mas em 2011 apareceram desaprovações sérias em outros itens do questionário.

Embora em pequeno número, é preciso relatar o que foi classificado como

“vermelho”:

1.

Organização

Ruim. – Dificuldade na utilização das

ferramentas.

2. Conteúdo

Superficial

e mal conduzida.

3. Habilidade de comunicação

Ruim.

Professora tem dificuldade em se comunicar.

Ruim. Repetitiva.

4. Habilidades técnicas de ensino (Didática)

Ruim.

Não tem Didática. Para montar a aula.

Ruim.

Aula muito cansativa.

Regular.

Frases incompletas. Deixa a desejar, talvez pela sua limitação física.

5. Domínio do Conteúdo

Péssimo.

Não se agrada 100% do público, mas um ponto precisa ser colocado: quando, em uma avaliação,

o aluno diz apenas que o professor é péssimo, que não sabe a disciplina que

ministra, e frases do gênero, expressa convicção, mas não se apoia em fatos, nem traz colaboração para melhorar o

ensino. No discurso literário se permite arrogância, mas não em quem julga com

ética. O compromisso de quem se propõe a fazer pós-graduação em Bioética é de

que se atenha à realidade dos fatos, com explicações condizentes, ancorado

5. Conclusões

1. Somos imediatistas. Alguns

pós-graduandos cometem o erro de pensar que podem aprender “só” para fazer o

trabalho de final de curso – no caso, uma dissertação. Nada de saber como ler

artigos científicos9, ou seja, nada de entender como os outros

pesquisam – querem ser monocórdios. Só que pesquisador tem de estudar. Então

continuarei insistindo no trato de pesquisa quantitativa, tanto quanto da qualitativa10.

2. A ojeriza à

estatística está fincada em dois componentes lamentáveis: a falta de

conhecimento em matemática11 e a falta de, simplesmente, saber o que

é estatística12. Há que investir na base, ou seja, no ensino

fundamental, para que não se chegue à pós-graduação sem entender cálculo de porcentagens.

Porque alfabetização (em matemática) precisa ser dada na hora certa. Ou “vamos involuir de Einstein para Galileu”13?

6. Referências

1. Castro, CM. Os professores e a regra de três. http://veja.abril.com.br/221008/ponto

de_vista.html

2.

Berelson,

B. Content analysis in communication research. New York,

Free Press, 1952. In: Palmquist, MContent Analysis. http://www.colostate.edu/Depts/WritingCenter/references/research/content/page2.htm

3.

Stemler,

S. An Overview of Content Analysis http://pareonline.net/getvn.asp?v=7&n=17

4.

Bardin, L Análise de conteúdo. São Paulo, Edições

70, 2011.

Visser, C. Learning to compliment effectively.

6.

Castro, CM. Os tropeços da razão. http://veja.abril.com.br/031203/ponto_de_vista.html

7. Salzburg, D. Uma

senhora toma chá... como a estatística revolucionou a ciência no século XX. Rio

de Janeiro: Zahar, 2009.

8.

Mlodinov, L. O

andar do bêbado. Rio de Janeiro: Zahar, 2009.

9.

Greenhalgh, T.

Como ler artigos científicos. 2ed. Porto Alegre: Artmed, 2005.

10. Denzin, NK, Lincoln, YS. O planejamento da

pesquisa qualitativa. 2ed. Porto Alegre: Artmed, 2006.

11. Flick, U. Uma introdução à pesquisa

qualitativa. 2ed. Porto Alegre: Bookman, 2004.

12 Pope C, Mays, N. Pesquisa qualitativa. 2ed.

Porto Alegre: Artmed, 200

13. Brasil melhora em matemática, mas

continua entre piores. - Estadão www.estadao.com.br › Educação

14. Vieira, S, Wada, R. O que é estatística.

São Paulo: Brasiliense

15. Castro, CM. Os tropeços da razão. http://veja.abril.com.br/031203/ponto_de_vista.html

PS. Este texto foi publicado em Bioethikós (Centro Universitário São Camilo), v. 6, p. 335, 2012. VIEIRA, S. Análise de conteúdo da avaliação dos alunos sobre Metodologia da Pesquisa. Décadas passadas, espero que a aceitação da Estatística como ciência tenha melhorado entre meus ex-alunos. Mas - sobretudo - espero que os mais jovens estejam adquirindo uma visão melhor dessa ciência tão fundamental para o desenvolvimento humano e do planeta, em geral.

[1] René Descartes viveu no século XVII.

No comments:

Post a Comment