A análise

de regressão permite estabelecer um modelo para descrever a relação entre

duas ou mais variáveis. Trata-se de uma técnica que possibilita fazer previsões

sobre uma variável – chamada variável resposta (dependente) – com base em

informações obtidas de outras variáveis – conhecidas como variáveis explicativas (também chamadas de explanatórias,

preditoras ou independentes).

Regressão linear simples

A regressão

linear simples é denominada “linear” porque

o modelo ajustado é uma reta, e “simples” porque há

apenas uma variável explicativa. A regressão linear simples é definida

pelo modelo:

Nesse

modelo, os pares de variáveis Yi e Xi (i=1,

2, ..., n) representam a variável resposta e a variável explicativa,

respectivamente; b0 e b1 são

parâmetros a serem estimados a partir dos dados e eij (i=1, 2, ..., n) são

erros aleatórios.

Por

exemplo, ao analisar um conjunto de dados de peso e altura de jovens que se

apresentaram para o serviço militar, pode-se supor que peso seja função linear

da altura. Ajustando uma reta a esses dados, obtém-se as estimativas b0 e b1 dos

parâmetros b0 e b1 da regressão.

O

termo b0 é o coeficiente linear, também conhecido como

intercepto (intercept, em inglês) e o termo b1 é o coeficiente angular, também conhecido como

inclinação (slope, em inglês). A reta ajustada aos dados,

considerada a melhor, no sentido de possuir propriedades estatísticas

desejáveis, é chamada de reta

de regressão. Muitos autores também a denominam reta

de mínimos quadrados, em referência ao método estatístico utilizado

para calcular as estimativas.

Regressão linear múltipla

A regressão

linear múltipla (multiple linear regression) é uma técnica estatística

que usa diversas variáveis explicativas

para prever a variável resposta. Logo, a regressão linear múltipla

estabelece o modelo para uma relação linear entre a variável

resposta (dependente) e diversas variáveis explicativas

(independentes).

Nessa

fórmula, Yi (i =1, 2,...,n) são

as n observações da variável resposta (dependente) e Xi1, Xi2,...,Xik são

as n observações das k variáveis explicativas

(independentes). O coeficiente b0 é o intercepto e b1, b2,..., bk são

os coeficientes angulares correspondentes a cada variável explicativa. Os

termos ei são os erros do modelo.

Para ajustar um modelo de regressão linear múltipla, algumas pressuposições deve ser atendidas.

Pressuposições

🔸A variável

resposta (dependente) deve ser contínua.

🔸Deve haver

uma relação linear entre a variável resposta e cada uma das variáveis

explicativas.

🔸As observações

das variáveis explicativas devem ser independentes entre si.

🔸Os desvios devem

ter distribuição normal de média zero e variância s2.

Vamos

mostrar, por meio de um exemplo, como ajustar uma regressão

linear múltipla a um conjunto de dados utilizando o SPSS (Statistical

Package for Social Sciences). Em outra postagem, explicaremos como

interpretar os resultados.

Exemplo

Considere uma amostra aleatória de 12 crianças atendidas em uma clínica. O peso, a altura e a idade dessas crianças estão apresentados abaixo, já formados para inserção no SPSS. O peso (weight) está em libras, a altura (height) em pés e a idade (age) em anos completos. Nosso objetivo é estudar o peso em função da altura e da idade.

As

etapas dadas em seguida mostram como realizar a análise de regressão linear

múltipla no SPSS, supondo que todas as pressuposições do modelo foram

atendidas. Ao final, exibiremos os resultados da regressão.

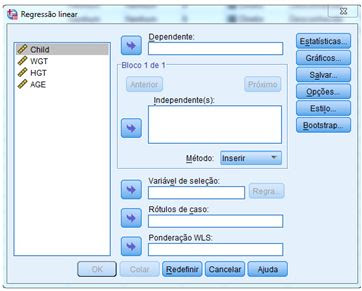

🔸 No menu principal do SPSS, clique em Analisar > Regressão > Linear.

🔸 Você será apresentado à caixa

de diálogo.

🔸 Transfira a variável dependente peso (WGT) para a caixa “Dependente” e as variáveis independentes altura (HGT) e idade (AGE) para a caixa “Independente” utilizando o botão de transferência apropriado.

🔸 Clique em Estatísticas. Na caixa

de diálogo que se abrirá, selecione as opções Estimativas e Ajuste do

Modelo.

🔸 Clique em Continuar para retornar à caixa de diálogo principal da Regressão linear.

🔸 Clique em OK. Será gerada a Saída, com os resultados.

✅ Saída dos Resultados

No comments:

Post a Comment