Você rodou uma regressão linear

múltipla no SPSS e… foi recebido com uma avalanche de tabelas? Calma, isso é

mais comum do que parece — mas a boa notícia é que você não precisa se perder

nos números.

Neste post, vamos direto ao ponto

e te mostrar as

três tabelas mais importantes da saída do SPSS que todo mundo que analisa

regressão múltipla precisa entender. Com explicações claras e

exemplo prático, você vai aprender a interpretar os valores de R, R², ANOVA e os

coeficientes como um especialista — mesmo que esteja começando agora.

Resumo do Modelo

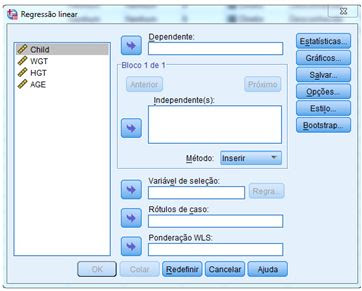

Para proceder

ao cálculo da regressão linear múltipla, vamos utilizar o exemplo dado na

postagem anterior (Regressão linear múltipla no SPSS). Os dados estão repetidos

na tabela apresentada abaixo.

Com esses

dados, obtivemos a primeira tabela de interesse, isto é, a tabela Resumo do

Modelo. Esta tabela fornece R, R2, R2 ajustado

e o erro padrão da estimativa, que pode ser usado para determinar quão bem

um modelo de regressão se ajusta aos dados.

O valor R é o

coeficiente de correlação múltipla. É uma medida da qualidade da

previsão da variável dependente, que neste exemplo é o peso da criança, (WGT),

dado em libras. Um valor de 0,883 indica bom nível de previsão.

O

valor R2 é o coeficiente de determinação. É a

proporção de variação na variável dependente explicada pelas variáveis independentes.

O valor R2 =

0,780 mostra que as variáveis independentes explicam 78,0% da variação da variável

dependente, WGT (peso). Você também precisa

saber interpretar "R2 ajustado", mas vamos

explicar isso em próxima postagem.

Tabela de análise de variância (ANOVA)

A segunda

tabela de interesse é a tabela de análise de variância, ou tabela de ANOVA (do

inglês, ANOVA table), mostrada em seguida.

O teste F (indicado como

"Z" na tabela ANOVA) avalia o ajuste do modelo de regressão. A tabela

mostra que as variáveis independentes (AGE e HGT) predizem significativamente a

variável dependente (WGT), já que p < 0,05. Em outras

palavras, o modelo de regressão se ajusta bem aos dados.

Coeficientes

de regressão

A terceira

tabela de interesse é aquela que apresenta os coeficientes de regressão. Veja

em seguida.

Coeficientes

não padronizados indicam quanto a variável dependente varia com cada

variável independente, mantendo-se as demais constantes. Considere o efeito da idade, neste

exemplo: o coeficiente não padronizado para idade (AGE) é igual a

2,050. Isso significa que, para cada aumento de um ano na idade, espera-se um

aumento de 2,050 libras no peso (WGT) (lembre-se de que peso está medido em

libras).

O

teste t, apresentado na tabela, testa se os coeficientes (padronizados

ou não) são iguais a zero na população. Se p < 0,05, conclui-se

que os coeficientes são significantemente diferentes de zero. Os valores do

teste t e seus respectivos valores p estão

localizados nas colunas "t" e "Sig", respectivamente. Observe

que o coeficiente de altura (HGT) é significante.

Conclusão

Foi ajustada uma regressão linear múltipla para prever o peso em função da altura e da idade de crianças. Obteve-se:

✅ Apenas a variável altura (HGT) foi significativa ao nível de 5%. A variável idade (AGE), com p = 0,056, pode ser considerada significativa em um nível próximo ao convencional de 5%. Veja a figura na abertura deste post.

Observação

A amostra

é muito pequena e composta por dados fictícios. Portanto, as conclusões não são

válidas na prática. Este exemplo foi utilizado apenas para facilitar os

cálculos e fornecer uma referência importante ao leitor (KLEINBAUM e KUPPER).

Os dados não foram convertidos para o sistema métrico decimal porque

resultariam em valores não inteiros, o que dificult